BIZNESOWY PUNKT WIDZENIA

Big data pozwala firmom opracowywać innowacyjne strategie zmierzające do usprawnienia procesu logistycznego. Dzięki analizie danych, generowanych każdego dnia w magazynie, kierownictwo może na bieżąco identyfikować obszary wymagające poprawy i podejmować strategiczne decyzje biznesowe.

W ciągu ostatnich pięciu lat znacząco wzrosła liczba urządzeń podłączonych do internetu. Z badania przeprowadzonego przez firmę konsultingową International Data Corporation wynika, że w 2025 roku na świecie będzie ponad 41 miliardów inteligentnych urządzeń, które wygenerują przeszło 79,4 zettabajtów danych.

Coraz bardziej ogromne zbiory danych, zwane big data, stanowią potężne narzędzie w zarządzaniu organizacjami, ułatwiając doskonalenie procesów i podejmowanie decyzji. Jak wskazuje firma konsultingowa Gartner, „big data to aktywa informacyjne o dużej objętości, dużej zmienności i dużej różnorodności, które wymagają wydajnych, innowacyjnych metod przetwarzania informacji, umożliwiających lepsze rozumienie, planowanie i automatyzowanie procesów”.

Analiza big data ma za zadanie wydobyć z dużych zbiorów danych użyteczne informacje. W ostatnim czasie na rynku pojawiły się liczne technologie służące do grupowania i przetwarzania danych. Są one w stanie gromadzić i obsługiwać ogromne ilości informacji, których analiza za pomocą tradycyjnego oprogramowania byłaby niemożliwa.

Technologia big data jest obecnie stosowana we wszystkich procesach i obszarach działalności przedsiębiorstwa, od produkcji w celu zwiększenia jej wydajności po marketing w celu segmentacji rynku i poprawy wyników sprzedaży.

Dlaczego big data ma tak wielkie znaczenie w biznesie?

Dzięki analizie big data firmy mogą przetwarzać i badać ogromną ilość powstających w nich danych, aby w ten sposób znajdować nowe możliwości. Gromadzenie i analiza potężnej ilości cyfrowych danych zapewnia firmom możliwość odkrycia nowych perspektyw rozwoju.

Naukowcy z Uniwersytetu Turyńskiego (Włochy) w badaniu pt. Big data analytics capabilities and knowledge management: impact on firm performance wskazują, że „dzięki technologii big data dane można analizować i kategoryzować, co pozwala pozyskać przydatne dla przedsiębiorstw informacje, które z kolei można wykorzystać w procesie decyzyjnym, by zwiększyć produktywność”.

To właśnie w podejmowaniu decyzji biznesowych big data zaczyna mieć kluczowe znaczenie. Multidyscyplinarne badania przeprowadzone przez naukowców z Anderson School of Management (USA) i College of Economics and Management (Chiny) potwierdzają strategiczną rolę big data w biznesie: „Uzyskane wyniki empiryczne pokazują, że wykorzystanie analityki big data ma pozytywny wpływ na jakość podejmowanych decyzji”. Autorzy badania, opublikowanego w czasopiśmie „Technological Forecasting and Social Change”, zwracają uwagę na potencjał analityki big data w zakresie poprawy konkurencyjności przedsiębiorstw: „Przedsiębiorstwa powinny nie tylko dążyć do korzystania z big data w swojej działalności, ale także doskonalić swoje zdolności w zakresie analizy tych danych, gdyż przełoży się to na lepsze decyzje i przewagę konkurencyjną”.

Big data w łańcuchu dostaw

Big data otwiera ogromne możliwości dla osób odpowiedzialnych w przedsiębiorstwie za funkcjonowanie łańcucha dostaw. Według raportu Ernest & Young 61% ankietowanych przedstawicieli kadry kierowniczej planuje wdrożenie analityki big data w ciągu najbliższych trzech lat, natomiast 33% prowadzi aktualnie testy pilotażowe lub stosuje narzędzia do analizy ogromnych zbiorów danych w niektórych obszarach łańcucha dostaw swojej firmy.

Analityka danych może przynieść korzyści w takich obszarach jak produkcja, magazynowanie, transport i sprzedaż. W publikacji pt. Big data analytics in supply chain management naukowcy z Uniwersytetu Zachodniego Illinois (USA) zauważają, że „analiza big data w zarządzaniu łańcuchem dostaw zapewnia wiele korzyści, takich jak możliwość prognozowania podaży i popytu, analizowania zmian preferencji klientów czy poprawiania widoczności łańcucha dostaw oraz jego odporności na ryzyka”.

Dzięki narzędziom big data w łańcuchu dostaw wdrażane są metody analityczne, które umożliwiają podejmowanie decyzji na podstawie pozyskanych danych. „Analityka big data pozwala skuteczniej przewidzieć potrzeby klientów, ocenić efektywność łańcucha dostaw, poprawić jego wydajność, skrócić czas reakcji oraz oszacować wszelkiego rodzaju ryzyko” – twierdzą badacze z Concordia Institute for Information Systems Engineering (Kanada).

Supply Chain Analytics Software, czyli analiza big data w magazynie

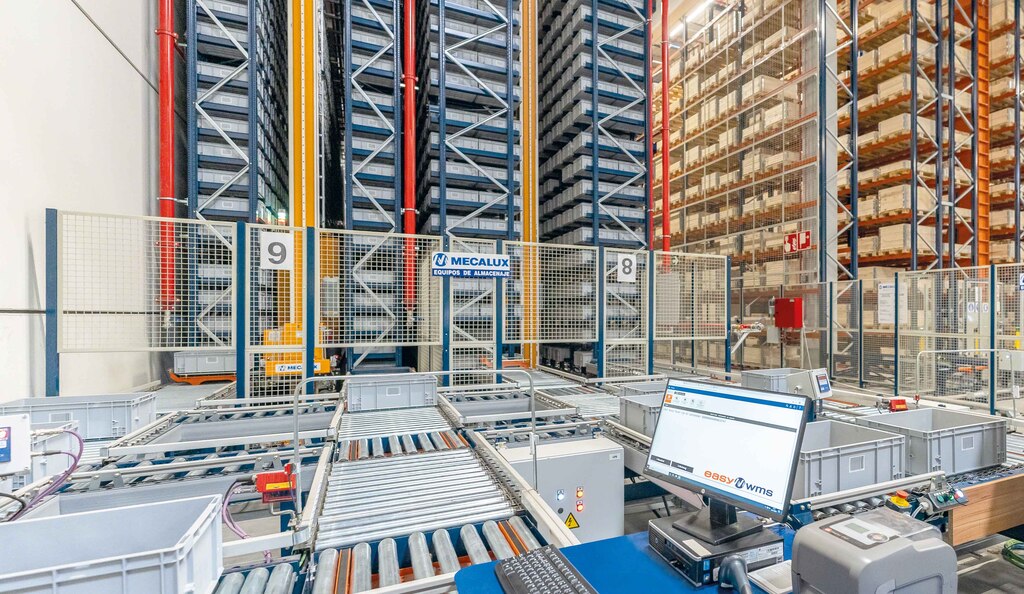

Postępująca cyfryzacja logistyki determinuje wzrost liczby urządzeń podłączonych do internetu, które generują ogromne ilości danych. Aby ułatwić ich analizę i interpretację, Mecalux opracował Supply Chain Analytics Software, rozszerzenie funkcjonalności systemu zarządzania magazynem Easy WMS. Moduł ten grupuje i strukturyzuje dane powstające w trakcie pracy magazynu.

Przetworzenie tych danych w użyteczne informacje sprawia, że osoby odpowiedzialne w firmie za logistykę mogą z większą łatwością wprowadzać niezbędne usprawnienia. Supply Chain Analytics Software bowiem klasyfikuje dane, przekształcając je we wskaźniki, które przedstawiają w czasie rzeczywistym obiektywny obraz przebiegu procesu, a także umożliwiają analizę historyczną pracy magazynu.

Moduł wyświetla panele i wykresy z podstawowymi informacjami, takimi jak poziom zajętości magazynu czy odsetek przygotowanych zamówień. Umożliwia również skonfigurowanie własnych wskaźników wydajności zgodnie z potrzebami firmy.

Supply Chain Analytics Software wspiera wydajną logistykę, która elastycznie dopasowuje się do bieżących potrzeb firmy. Na przykład hiszpański dystrybutor produktów do pakowania i etykietowania Intermark wdrożył w swoim magazynie program Mecaluxu, aby móc dokładnie monitorować cały proces logistyczny: „Moduł zapewnia nam podgląd procesu i pomaga wprowadzać usprawnienia na podstawie wskaźników obrazujących jego codzienne funkcjonowanie. Nasz rynek jest bardzo dynamiczny, a wymogi klientów szybko się zmieniają, co zmusza nas do ciągłego dostosowywania działalności do tych zmian. Dzięki modułowi dysponujemy teraz informacjami opartymi na danych, które pozwalają nam podejmować właściwe decyzje, by nasza logistyka działała zawsze perfekcyjnie” – wyjaśnia Juan Pablo Calvo, Dyrektor Generalny firmy Intermark.

Analiza big data dostarcza firmom wiarygodne i obiektywne dane, które pozwalają modyfikować i optymalizować procesy: „Easy WMS doskonale dopasowuje się do specyfiki naszej działalności. Dzięki niemu zawsze znamy dostępność towaru i przeprowadzamy inwentaryzację w czasie rzeczywistym” – mówi James Hansen, Wiceprezes Wykonawczy w firmie Yamazen. Amerykański oddział japońskiego dystrybutora obrabiarek wykorzystuje moduł Supply Chain Analytics Software do analizy wydajności procesu magazynowego.

Mecalux wdrożył moduł Supply Chain Analytics Software w wielu obiektach logistycznych na całym świecie należących do przedsiębiorstw z różnych branż. Dzięki temu narzędziu firmy wykorzystują big data, aby móc sprawować lepszą kontrolę nad przebiegiem wszystkich operacji w łańcuchu dostaw.

Siła danych motorem logistyki

Firmy korzystają z najnowszych technologii w celu gromadzenia, przetwarzania oraz analizowania ogromnych ilości danych, które każdego dnia są generowane w różnych obszarach działalności. Informacje pozyskane w wyniku tej analizy zapewniają szereg korzyści i nowych możliwości, takich jak optymalizacja procesów, planowanie inwestycji czy wprowadzanie na rynek nowych produktów.

Analiza big data jest przydatna we wszystkich branżach, jednakże w sektorze logistycznym stanowi nieodzowne narzędzie, które sprzyja poprawie konkurencyjności przedsiębiorstwa.

Big data, czyli historia rewolucji

W 1997 roku badacze z NASA Michael Cox i David Ellsworth wprowadzili pojęcie big data w pracy zatytułowanej Application-controlled demand paging for out-of-core visualisation. „Wizualizacja procesów stanowi interesujące wyzwanie dla systemów komputerowych: zbiory danych są często duże i obciążają pojemność pamięci głównej, dysku lokalnego, a nawet dysku zdalnego. Nazywamy to problemem big data”.

Na początku XXI wieku upowszechnianie się internetu zaczęło otwierać nowe możliwości w zakresie gromadzenia i analizy danych. Rozwój internetowych platform sprzedażowych spowodował, że firmy takie jak eBay czy Amazon skupiły się na analizie zachowań klientów w celu zwiększenia sprzedaży. Popularność mediów społecznościowych natomiast zaowocowała wzrostem zapotrzebowania na narzędzia umożliwiające organizację ogromnej ilości nieustrukturyzowanych danych pochodzących z sieci. Kolejnym kamieniem milowym było pojawienie się internetu rzeczy (IoT) i uczenia maszynowego – dzięki tym technologiom rośnie liczba urządzeń podłączonych do internetu, a tym samym ilość danych, z których można pozyskać użyteczne informacje.

Chociaż narzędzia do analizy big data przynoszą już sporo korzyści, kolejne osiągnięcia technologiczne, takie jak chmura obliczeniowa, otwierają coraz to nowe możliwości wykorzystywania potencjału danych i ich analizy w optymalizacji wydajności przedsiębiorstw.

5V, czyli 5 cech big data

Big data, czyli wielkie zbiory danych, charakteryzują się następującymi cechami:

- Objętość (ang. volume): ogromna ilość danych pochodzących z wielu źródeł musi być obsługiwana z zastosowaniem nowych, zaawansowanych metod przechowywania, wykorzystywania oraz zarządzania.

- Szybkość (ang. velocity): szybkie tempo ciągłego i masowego narastania danych wymaga sprawnych narzędzi do gromadzenia i przetwarzania, aby nie doszło do ich dezaktualizacji.

- Różnorodność (ang. variety): narzędzia do analizy big data powinny być w stanie obsługiwać dane zróżnicowane pod względem struktury i treści, obejmujące nie tylko dane tekstowe, ale i m.in. obrazy, audio i wideo, w tym np. pochodzące z programów informatycznych, mediów społecznościowych i platform sprzedażowych.

- Wiarygodność (ang. veracity): w analizie big data ważna jest jakość i dokładność danych, dlatego konieczna jest ich weryfikacja i selekcja.

- Wartość (ang. value): właściwy dobór oraz prawidłowa interpretacja danych pozwala na uzyskanie informacji o dużej wartości dla organizacji.